Truffe con intelligenza artificiale generativa: come l’IA viene usata per ingannare

Negli ultimi anni, le minacce informatiche sono cambiate radicalmente: grazie all’intelligenza artificiale generativa, i truffatori hanno accesso a strumenti sempre più raffinati, capaci di ingannare anche gli utenti più esperti. Non stiamo più parlando delle classiche email di phishing piene di errori grammaticali o dei tentativi grossolani di imitare siti web legittimi. L’IA generativa ha innalzato drasticamente il livello delle truffe online, rendendo la distinzione tra contenuti autentici e fraudolenti una sfida anche per gli utenti più esperti e attenti. Questo fenomeno rappresenta una preoccupazione crescente sia per i singoli individui che per le organizzazioni, poiché i cybercriminali stanno rapidamente adottando queste tecnologie per rendere i loro attacchi più convincenti, personalizzati ed efficaci. La capacità dell’intelligenza artificiale di apprendere, adattarsi e generare contenuti che sembrano autentici ha trasformato il modo in cui vengono orchestrate le truffe online, creando un ambiente in cui anche gli utenti più cauti possono cadere vittima di schemi fraudolenti sofisticati. Nei prossimi paragrafi esploreremo in dettaglio come l’IA generativa stia rivoluzionando le tattiche di frode, le varie forme che queste truffe possono assumere e le strategie che possiamo adottare per proteggerci in questo nuovo e insidioso panorama digitale.

Il phishing potenziato dall’intelligenza artificiale rappresenta una delle minacce più prevalenti e pericolose nel panorama attuale della cybersicurezza. I tradizionali attacchi di phishing erano spesso caratterizzati da errori grammaticali evidenti, loghi di bassa qualità e un approccio generalizzato che poteva essere facilmente identificato da utenti attenti. Tuttavia, con l’avvento di modelli linguistici avanzati come GPT-4 e Claude, i cybercriminali hanno ora a disposizione strumenti che possono generare testi impeccabili, privi di errori e perfettamente adattati al contesto. Questo significa che le email di phishing non solo appaiono professionali, ma possono essere personalizzate sulla base delle informazioni raccolte sui potenziali bersagli, rendendo questi attacchi significativamente più convincenti. I criminali informatici possono creare messaggi che imitano perfettamente lo stile comunicativo di aziende legittime, utilizzando termini tecnici corretti e facendo riferimento a dettagli specifici che aumentano la percezione di autenticità. Per esempio, un truffatore potrebbe generare un’email che sembra provenire dalla banca della vittima, menzionando dettagli come il tipo di conto corrente posseduto o recenti transazioni, informazioni che potrebbero essere state raccolte attraverso data breach o social engineering. Inoltre, l’IA può essere programmata per analizzare le risposte delle vittime e adattare le successive comunicazioni di conseguenza, creando uno scambio che sembra naturale e legittimo. Alcuni criminali particolarmente sofisticati stanno anche sfruttando l’IA per automatizzare la creazione di siti web di phishing che replicano perfettamente le piattaforme legittime, con layout, colori e funzionalità identiche agli originali. La combinazione di email convincenti e siti web fraudolenti praticamente indistinguibili dagli originali sta rendendo il phishing basato sull’IA una minaccia estremamente efficace contro cui è sempre più difficile difendersi.

Le imitazioni vocali basate sull’intelligenza artificiale stanno emergendo come uno degli strumenti più insidiosi nell’arsenale dei truffatori digitali. La tecnologia di clonazione vocale è avanzata al punto che, con appena pochi minuti di audio campione, l’IA può generare una replica quasi perfetta della voce di una persona. Questa capacità ha dato origine a una forma piuttosto pericolosa di frode nota come “vishing” (voice phishing) potenziato dall’IA. I criminali informatici stanno sfruttando queste tecnologie per impersonare figure di autorità, come dirigenti aziendali, rappresentanti di istituzioni finanziarie o persino familiari delle vittime. Un esempio allarmante di questa tattica è la cosiddetta “truffa del CEO”, in cui i truffatori clonano la voce di un amministratore delegato o di un alto dirigente per contattare dipendenti con accesso a informazioni sensibili o con autorità per effettuare trasferimenti di denaro. In un caso documentato, i criminali hanno utilizzato l’IA per clonare la voce del CEO di un’azienda energetica britannica, convincendo un manager a trasferire urgentemente 243.000 euro a un fornitore straniero. La vittima ha riferito che la voce era così convincente, compresi l’accento e il tono caratteristici del suo capo, che non ha mai sospettato si trattasse di una frode. In ambito personale, i truffatori stanno anche prendendo di mira individui impersonando i loro familiari in situazioni di emergenza. Una tattica comune consiste nel contattare una persona anziana, fingendosi il nipote o figlio in difficoltà che necessita di un trasferimento di denaro immediato. L’uso dell’IA per clonare la voce del familiare rende questi tentativi estremamente convincenti, sfruttando la reazione emotiva del destinatario e lasciando poco tempo per verificare l’autenticità della richiesta. Ciò che rende queste truffe efficaci è che la comunicazione vocale è tradizionalmente considerata più affidabile dell’email o dei messaggi di testo, e molte persone non sono ancora consapevoli che le voci possono essere clonate con tale precisione.

I deepfake, ovvero video e immagini manipolati o completamente generati dall’intelligenza artificiale, rappresentano una delle manifestazioni più preoccupanti dell’IA generativa nel contesto delle truffe online. Questa tecnologia, che utilizza reti neurali profonde per sovrapporre volti esistenti su video di altre persone o per creare contenuti visivi realistici dal nulla, ha fatto progressi straordinari negli ultimi anni. Oggi i deepfake sono così realistici che, a colpo d’occhio, distinguere un video autentico da uno manipolato è diventato quasi impossibile. I truffatori stanno sfruttando questa tecnologia in vari modi ingegnosi e dannosi. Una delle applicazioni più diffuse è la creazione di falsi video di celebrità o personalità influenti che promuovono schemi di investimento fraudolenti, soprattutto nel settore delle criptovalute. Questi video, che circolano ampiamente sui social media, mostrano figure note che sembrano genuinamente entusiaste di piattaforme di investimento che promettono rendimenti eccezionali. Molti utenti, fidandosi della reputazione della celebrità, investono in questi schemi solo per scoprire che si tratta di truffe elaborate. Un altro uso allarmante dei deepfake è nelle truffe di identità e reputazione. I criminali possono creare video di individui in situazioni compromettenti o fare dichiarazioni false, utilizzandoli poi per ricattare le vittime o danneggiare la loro reputazione. In ambito aziendale, i deepfake sono stati utilizzati per impersonare dirigenti in videochiamate, dando istruzioni a dipendenti per trasferire fondi o divulgare informazioni sensibili. In un caso documentato, i truffatori hanno utilizzato un deepfake di un CFO durante una videoconferenza per autorizzare un trasferimento fraudolento di 25 milioni di dollari. Ciò che rende i deepfake veramente pericolosi è che sfruttano la tendenza umana a fidarsi di ciò che vediamo con i nostri occhi. Inoltre, la velocità con cui questi contenuti possono diffondersi sui social media significa che il danno può essere fatto molto prima che la vittima sia consapevole dell’esistenza del deepfake.

L’impersonificazione attraverso profili falsi potenziati dall’IA sta diventando una minaccia crescente nel panorama delle truffe online. A differenza dei bot primitivi o dei profili finti che erano relativamente facili da identificare, l’intelligenza artificiale generativa permette ora di creare identità digitali estremamente realistiche e coerenti. Queste false persone digitali, talvolta chiamate “synthetic identities”, sono costruite utilizzando un mix di informazioni rubate, dati inventati e contenuti generati dall’IA. I truffatori utilizzano modelli di IA avanzati per creare foto profilo realistiche di persone che non esistono, generare biografie convincenti e persino produrre contenuti social media che mostrano una storia personale coerente nel tempo. Questi profili falsi vengono poi utilizzati per una varietà di schemi fraudolenti. Nel contesto delle truffe romantiche, per esempio, l’IA viene impiegata per mantenere conversazioni complesse e personalizzate con più vittime contemporaneamente, adattandosi alle loro risposte e creando l’illusione di una connessione emotiva genuina. Questi profili IA possono interagire con le vittime per mesi, costruendo fiducia prima di introdurre richieste di denaro o informazioni sensibili. In ambito professionale, i criminali stanno creando profili LinkedIn convincenti di persone inesistenti che sembrano lavorare per aziende rispettabili. Questi profili vengono utilizzati per networking, raccolta di informazioni aziendali sensibili o per proporre false opportunità di investimento o collaborazione. La capacità dell’IA di analizzare le interazioni passate e adattare le comunicazioni future rende questi profili falsi eccezionalmente convincenti. Un aspetto insidioso di questa minaccia è che i profili falsi basati sull’IA possono costruire una presenza online coerente su più piattaforme – con account coordinati su LinkedIn, Facebook, Twitter e altri social media, tutti che pubblicano contenuti coerenti e interagiscono in modo naturale, creando così l’illusione di una persona reale con una vita digitale autentica.

La generazione di documenti falsi attraverso l’intelligenza artificiale sta rivoluzionando le truffe di identità in modi che erano impensabili solo pochi anni fa. Le tecnologie di IA generativa sono ora in grado di produrre documenti ufficiali contraffatti di qualità eccezionale, inclusi passaporti, patenti di guida, certificati di nascita, diplomi e documentazione finanziaria. La sofisticazione di questi falsi è tale che possono ingannare non solo individui comuni ma anche, in alcuni casi, i sistemi di verifica automatizzati. I truffatori utilizzano modelli di diffusione e GAN (Generative Adversarial Networks) per creare immagini ad alta risoluzione di documenti che includono tutti gli elementi di sicurezza visibili: filigrane, ologrammi, microstampe e persino caratteristiche reattive agli UV. Questi documenti falsi vengono poi utilizzati per una vasta gamma di attività fraudolente, dal furto di identità all’apertura di conti bancari fraudolenti, fino all’ottenimento di prestiti o carte di credito a nome delle vittime. Un’applicazione preoccupante è l’uso combinato di documenti falsi generati dall’IA con deepfake in tempo reale durante le procedure di verifica dell’identità online. I criminali possono presentare un documento falso mentre, simultaneamente, utilizzano un deepfake per “animare” la foto del documento durante una videochiamata di verifica, superando così i controlli di “prova di vita”. In ambito aziendale, l’IA viene utilizzata per falsificare documenti finanziari, dichiarazioni fiscali o certificazioni professionali per ingannare investitori, partner commerciali o potenziali datori di lavoro. La qualità di questi falsi è tale che spesso è necessaria un’analisi forense approfondita per identificarli. La facilità con cui questi documenti possono essere generati rappresenta una seria minaccia per i sistemi di verifica dell’identità e richiede l’implementazione di contromisure sempre più sofisticate da parte delle organizzazioni che si affidano a questi documenti per prendere decisioni importanti.

I chatbot fraudolenti potenziati dall’intelligenza artificiale rappresentano un’evoluzione significativa rispetto ai tradizionali bot di truffa. Grazie ai progressi nei modelli linguistici come GPT e similari, questi chatbot sono ora in grado di sostenere conversazioni naturali, rispondere a domande complesse e adattarsi dinamicamente alle interazioni degli utenti. Questa sofisticazione li rende strumenti estremamente efficaci per vari tipi di frode. Uno degli impieghi più comuni di questi chatbot è nel campo del supporto tecnico fraudolento. I truffatori creano siti web che imitano i portali di supporto di aziende legittime, dove i chatbot IA interagiscono con le vittime, diagnosticano falsi problemi e indirizzano gli utenti verso soluzioni che comportano l’installazione di malware o la condivisione di informazioni sensibili. La naturalezza della conversazione e la capacità di rispondere in modo pertinente alle domande tecniche degli utenti rendono questi falsi sistemi di supporto super convincenti. Nel settore finanziario e degli investimenti, i chatbot IA vengono utilizzati per impersonare consulenti finanziari o rappresentanti di piattaforme di investimento legittime. Questi bot possono fornire analisi apparentemente sofisticate e personalizzate, rispondere a domande complesse sul mercato e gradualmente guadagnare la fiducia delle vittime prima di indirizzarle verso schemi di investimento fraudolenti. Un altro impiego preoccupante è nei siti di e-commerce fraudolenti, dove i chatbot IA offrono un’assistenza clienti apparentemente professionale, rispondendo a domande sui prodotti, gestendo reclami e persino negoziando sconti per aumentare la percezione di legittimità del sito. Ciò che rende i chatbot IA pericolosi è la loro scalabilità: un singolo truffatore può gestire simultaneamente migliaia di conversazioni convincenti, personalizzando l’approccio per ogni potenziale vittima. Inoltre, i modelli di IA più avanzati possono analizzare il linguaggio e il comportamento dell’utente per adattare le loro tattiche, mostrandosi più empatici con persone che sembrano emotivamente vulnerabili o più tecnici con utenti che sembrano sofisticati, massimizzando così l’efficacia dell’inganno.

La manipolazione delle recensioni e opinioni online attraverso l’intelligenza artificiale sta diventando una pratica sempre più diffusa e sofisticata. I truffatori utilizzano modelli linguistici avanzati per generare recensioni false che sono praticamente indistinguibili da quelle scritte da esseri umani. A differenza delle recensioni false tradizionali, che spesso presentavano schemi ripetitivi o erano chiaramente opera di non madrelingua, le recensioni generate dall’IA possono variare significativamente nello stile, nel tono e nel contenuto, evitando così gli algoritmi di rilevamento delle piattaforme. Questa tecnologia viene impiegata per gonfiare artificialmente la reputazione di prodotti, servizi o attività commerciali fraudolente, creando un’illusione di credibilità e popolarità. Un aspetto particolarmente ingannevole di questa pratica è l’uso dell’IA per generare “storie di cliente” dettagliate e convincenti, complete di specifiche tecniche accurate, descrizioni di esperienze d’uso e persino foto manipolate o generate del prodotto in uso. Queste recensioni elaborate possono influenzare significativamente le decisioni di acquisto, spingendo i consumatori verso prodotti contraffatti, servizi inesistenti o investimenti fraudolenti. I truffatori stanno anche utilizzando l’IA per creare false testimonianze video, in cui deepfake di persone inesistenti raccontano la loro positiva esperienza con un prodotto o servizio. Questo aggiunge un ulteriore livello di apparente autenticità difficile da contrastare. Nel contesto degli investimenti e delle criptovalute, l’IA viene impiegata per generare false discussioni sui forum finanziari, con multiple identità artificiali che sembrano confermare indipendentemente il successo di determinate strategie o piattaforme. Questo crea un falso consenso che può influenzare significativamente le decisioni degli investitori reali. La manipolazione dell’opinione pubblica attraverso l’IA non si limita al commercio, ma si estende anche alla disinformazione politica, dove viene utilizzata per creare l’apparenza di un ampio sostegno popolare per certe ideologie o figure politiche, potenzialmente influenzando il discorso democratico.

Le truffe basate su contenuti generati dall’IA nel settore delle notizie e dell’informazione rappresentano una minaccia significativa per la società contemporanea. I criminali informatici stanno sfruttando modelli linguistici avanzati per creare articoli di notizie false che sono stilisticamente indistinguibili da quelli prodotti da giornalisti professionisti. Questi falsi articoli possono includere citazioni inventate, statistiche manipolate e persino riferimenti a studi o rapporti che non esistono, il tutto presentato con un linguaggio e una struttura che imitano perfettamente le pubblicazioni legittime. Una tattica molto efficace è la creazione di siti web che imitano testate giornalistiche rispettabili, completi di layout professionali e nomi di dominio che differiscono solo leggermente dagli originali (come “buisinesswire.com” invece di “businesswire.com”). Questi siti possono pubblicare una miscela di notizie reali e false, rendendo più difficile per i lettori identificare i contenuti fraudolenti. I truffatori utilizzano questa strategia per vari scopi: manipolare i mercati finanziari attraverso false notizie su aziende quotate, promuovere schemi di investimento fraudolenti con falsi articoli che ne attestano il successo, o creare panico che porta a decisioni finanziarie impulsive. Per esempio, un falso articolo generato dall’IA che annuncia problemi normativi per una criptovaluta potrebbe innescare vendite di panico, permettendo ai truffatori di acquistare a prezzi artificialmente bassi. Oltre all’impatto finanziario diretto, queste truffe minano la fiducia nel giornalismo e nelle istituzioni. La capacità dell’IA di generare rapidamente grandi volumi di contenuti falsi, personalizzati per specifici pubblici target e ottimizzati per i motori di ricerca, rappresenta una sfida significativa per i fact-checker e i sistemi di verifica tradizionali. Veramente subdolo è l’uso dell’IA per creare contenuti “just-in-time” che sfruttano eventi di attualità o emergenze per massimizzare l’impatto emotivo e ridurre la probabilità che le vittime verifichino accuratamente le informazioni prima di agire.

Le truffe di social engineering potenziate dall’intelligenza artificiale rappresentano un’evoluzione significativa rispetto alle tecniche tradizionali, combinando la manipolazione psicologica con l’analisi dati avanzata e la personalizzazione automatizzata. I cybercriminali stanno utilizzando l’IA per analizzare enormi quantità di dati personali disponibili online – profili social, post pubblici, commenti, interazioni – per creare profili psicologici dettagliati delle potenziali vittime. Questi profili permettono di identificare vulnerabilità specifiche, come la propensione al rischio, la sensibilità a certi tipi di appelli emotivi o particolari preoccupazioni finanziarie o personali. Con queste informazioni, l’IA può generare approcci di manipolazione altamente personalizzati. Per esempio, un sistema di IA potrebbe identificare che una particolare vittima risponde positivamente a figure di autorità e ha recentemente espresso preoccupazioni per la sicurezza informatica. Il truffatore potrebbe quindi impersonare un esperto di sicurezza di una piattaforma che la vittima utilizza regolarmente, usando una terminologia specifica che risuona con le convinzioni della vittima. Le truffe di social engineering potenziate dall’intelligenza artificiale sono particolarmente efficaci, perché riescono a cambiare approccio in base alle risposte della vittima, rendendo l’inganno ancora più credibile. Se la vittima mostra esitazione, l’IA può ricalcolare l’approccio, magari cambiando tattica da un appello all’urgenza a uno basato sulla fiducia o sulla paura di perdere un’opportunità. I sistemi più sofisticati possono persino analizzare il linguaggio della vittima per identificare il suo stato emotivo attuale e adattare il tono di conseguenza. Un aspetto davvero inquietante è l’uso dell’IA per orchestrare attacchi multi-canale coordinati. Una persona potrebbe ricevere un’email apparentemente dalla propria banca, seguita da un messaggio sui social media che sembra provenire da un amico che ha avuto una buona esperienza con un particolare consulente bancario, e infine una chiamata dal “consulente” la cui voce è stata generata dall’IA. Questa consistenza attraverso diversi canali aumenta significativamente la percezione di legittimità. La natura automatizzata di questi attacchi significa che possono essere eseguiti su larga scala, con ogni vittima che riceve un approccio unico e personalizzato, aumentando drasticamente l’efficienza e l’efficacia delle campagne di frode.

Le truffe basate su falsi sistemi di elaborazione dei pagamenti rappresentano un’area in cui l’intelligenza artificiale generativa sta rendendo gli attacchi significativamente più sofisticati e difficili da individuare. I truffatori stanno utilizzando l’IA per creare repliche quasi perfette delle interfacce di pagamento di piattaforme legittime, complete di loghi, layout, animazioni e persino certificati di sicurezza apparentemente validi. Questi falsi gateway di pagamento possono apparire identici a quelli di PayPal, Stripe, banche o altri processori riconosciuti, creando un senso di familiarità e sicurezza nelle vittime. L’IA viene impiegata non solo per clonare l’aspetto visivo, ma anche per replicare l’intera esperienza utente, inclusi messaggi di conferma, email di notifica e persino numeri di riferimento della transazione che sembrano autentici. Alcuni sistemi fraudolenti più avanzati implementano l’intelligenza artificiale per adattarsi dinamicamente al dispositivo dell’utente, ottimizzando l’interfaccia per desktop o mobile e personalizzandola in base alla posizione geografica della vittima o alla banca emittente della carta, aumentando ulteriormente la percezione di legittimità. Un approccio che risulta essere insidioso consiste nell’intercettare le transazioni legittime in tempo reale. Quando un utente tenta di pagare su un sito web compromesso, viene reindirizzato a un gateway di pagamento fraudolento che raccoglie i dettagli della carta e successivamente utilizza questi dati per completare la transazione reale sul sito legittimo. In questo modo, l’utente riceve effettivamente il prodotto o servizio acquistato, eliminando uno dei principali segnali d’allarme delle truffe tradizionali. L’IA viene anche utilizzata per generare false email di assistenza clienti post-acquisto o notifiche di problemi con il pagamento, che sembrano provenire dai processori di pagamento legittimi ma in realtà indirizzano le vittime verso ulteriori tentativi di frode. Questa combinazione di ingegneria sociale e replica visiva precisa rende questi attacchi incredibilmente efficaci contro utenti che normalmente controllerebbero l’autenticità di un sito prima di inserire informazioni sensibili.

Il fenomeno dei quiz e sondaggi fraudolenti potenziati dall’intelligenza artificiale sta diventando sempre più comune e sofisticato nel panorama delle minacce online. A differenza dei classici questionari che miravano semplicemente a raccogliere dati personali, queste nuove versioni utilizzano l’IA per creare esperienze altamente interattive e personalizzate. I truffatori impiegano modelli di linguaggio avanzati per generare domande che sembrano innocue ma sono strategicamente progettate per estrarre informazioni sensibili o risposte che potrebbero essere utilizzate per indovinare password o rispondere a domande di sicurezza. Questi quiz spesso iniziano con domande generiche per stabilire un profilo di base dell’utente, per poi adattarsi dinamicamente in base alle risposte fornite, scavando sempre più a fondo in aree potenzialmente sensibili. L’IA consente di rendere questi questionari estremamente coinvolgenti, mescolando abilmente domande per puro intrattenimento con altre che raccolgono dati personali, il tutto mentre analizza le risposte per personalizzare le domande successive. Un’evoluzione preoccupante è l’integrazione di tecniche di gamification: i quiz possono includere timer, punteggi, confronti con altri utenti e ricompense virtuali per aumentare il coinvolgimento e incentivare la condivisione di informazioni. Questi elementi ludici riducono la vigilanza degli utenti e li incoraggiano a rispondere istintivamente piuttosto che ponderare attentamente quali informazioni stanno rivelando. I truffatori distribuiscono questi quiz principalmente attraverso i social media, spesso mascherandoli come test di personalità, sfide virali o offerte promozionali. L’intelligenza artificiale viene impiegata anche per creare annunci personalizzati che promuovono questi quiz, targetizzando utenti che hanno mostrato vulnerabilità specifiche nei loro comportamenti online. I dati raccolti vengono poi utilizzati per vari scopi illeciti, dal furto di identità alla creazione di profili dettagliati che possono essere venduti sul dark web o utilizzati per attacchi di phishing altamente personalizzati. La natura apparentemente innocua di questi quiz fa sì che molti utenti li completino e li condividano con la propria rete, amplificando significativamente la portata e l’efficacia di questi schemi fraudolenti.

Le truffe legate agli investimenti e alle criptovalute potenziate dall’intelligenza artificiale hanno raggiunto livelli di sofisticazione senza precedenti, combinando tecniche di persuasione psicologica con tecnologia avanzata. I truffatori stanno utilizzando l’IA per creare ecosistemi completi di disinformazione finanziaria che appaiono totalmente legittimi anche agli occhi di investitori esperti. Questi schemi truffaldini includono notizie false, resoconti fittizi di grandi successi e persino deepfake di investitori noti. A questo si aggiungono piattaforme di trading fasulle che simulano guadagni costanti, convincendo le vittime a investire. Un elemento chiave di queste truffe è l’uso dell’IA per creare dettagliati white paper tecnici che descrivono tecnologie blockchain inesistenti o progetti crittografici innovativi ma completamente fittizi. Questi documenti sono popolati di terminologia tecnica accurata, grafici sofisticati, diagrammi architetturali e persino riferimenti a ricerche accademiche (anch’esse spesso generate dall’IA o falsificate). L’intelligenza artificiale viene inoltre impiegata per simulare attività di mercato sulle piattaforme di investimento fraudolente, generando grafici e dati di trading che mostrano tendenze positive per incentivare ulteriori investimenti. Queste simulazioni possono essere personalizzate per mostrare a ogni utente risultati leggermente diversi, evitando così modelli riconoscibili che potrebbero segnalare una frode. Particolarmente insidiosi sono i “bot di trading IA” fraudolenti, che promettono rendimenti straordinari grazie a presunti algoritmi di machine learning in grado di prevedere i mercati. Questi bot spesso mostrano risultati simulati impressionanti durante periodi di prova gratuiti, ma una volta che gli utenti investono fondi reali, i soldi vengono semplicemente rubati. L’IA viene anche utilizzata per gestire comunicazioni personalizzate con migliaia di potenziali vittime simultaneamente, rispondendo a domande tecniche, fornendo false testimonianze e adattando le tattiche di persuasione in base alle preoccupazioni specifiche di ciascun investitore. I truffatori sfruttano l’hype attorno all’IA stessa, promuovendo falsi progetti di “criptovalute potenziate dall’IA” che promettono di rivoluzionare vari settori, cavalcando l’onda dell’entusiasmo tecnologico per mascherare schemi Ponzi o truffe exit scam.

Le truffe immobiliari potenziate dall’intelligenza artificiale stanno diventando sempre più sofisticate, sfruttando la natura ad alto valore e spesso emotiva delle transazioni immobiliari. I truffatori utilizzano modelli generativi di IA per creare inserzioni di proprietà completamente false ma estremamente convincenti, complete di descrizioni dettagliate, specifiche tecniche accurate e, soprattutto, immagini fotorealistiche di case o appartamenti che non esistono realmente. Queste immagini generate dall’IA possono includere esterni, interni, viste panoramiche e persino tour virtuali, tutti creati algoritmicamente ma praticamente indistinguibili da fotografie autentiche. Un approccio molto rischioso consiste nel combinare elementi reali con contenuti falsificati: i truffatori possono prendere inserzioni di proprietà genuine, modificarle significativamente con l’IA (cambiando posizione, caratteristiche o prezzi) e ripubblicarle come opportunità esclusive. In alcuni casi, utilizzano deepfake per impersonare agenti immobiliari legittimi in videochiamate con potenziali acquirenti o affittuari, aumentando ulteriormente la percezione di autenticità. L’intelligenza artificiale viene anche impiegata per generare falsa documentazione legale, come contratti di vendita, titoli di proprietà o permessi edilizi, tutti con filigrane, timbri e firme che sembrano autentici. Questi documenti vengono utilizzati per convincere le vittime a versare acconti, depositi cauzionali o persino pagamenti completi per proprietà che i truffatori non possiedono realmente o che non esistono affatto. Una variante emergente è la manipolazione di luoghi reali attraverso l’IA: le immagini di una proprietà effettivamente in vendita vengono modificate per rimuovere difetti evidenti, aggiungere caratteristiche desiderabili o alterare l’ambiente circostante (eliminando visivamente fonti di rumore come strade trafficate o aree industriali). Ciò che rende queste truffe particolarmente efficaci è la capacità dell’IA di personalizzare gli annunci in base alle preferenze della vittima: analizzando le ricerche immobiliari precedenti di un potenziale acquirente, i truffatori possono generare inserzioni che corrispondono esattamente ai suoi criteri ideali, creando “l’opportunità perfetta” che è difficile resistere.

L’impatto delle truffe basate sull’intelligenza artificiale generativa si estende ben oltre le perdite finanziarie immediate. Queste tecnologie stanno erodendo la fiducia nelle comunicazioni digitali e nelle istituzioni, creando un clima di scetticismo generalizzato che può avere conseguenze sociali profonde. Quando diventa impossibile distinguere con certezza tra contenuti autentici e generati artificialmente, le persone tendono a dubitare anche delle informazioni legittime, un fenomeno noto come “inflazione della sfiducia”. Questo può portare al rifiuto di informazioni fattuali importanti, come quelle relative alla salute pubblica o ai processi democratici, indebolendo il tessuto sociale. Inoltre, le vittime di queste truffe spesso sperimentano conseguenze psicologiche significative. A differenza delle frodi tradizionali, dove l’errore poteva essere attribuito a segnali di allarme ovvi che la vittima ha ignorato, le truffe basate sull’IA sono così sofisticate che anche le persone più caute e informate possono caderne vittima. Questo genera un profondo senso di vulnerabilità, vergogna e sfiducia che può portare all’isolamento sociale e alla riluttanza nell’utilizzare servizi digitali essenziali. Sul piano economico, la proliferazione di queste tecnologie fraudolente sta imponendo costi significativi alle imprese e alla società. Le aziende devono investire somme sempre maggiori in sistemi di sicurezza avanzati, mentre le istituzioni finanziarie affrontano perdite crescenti dovute a frodi che aggirano i tradizionali sistemi di rilevamento. Questi costi vengono inevitabilmente trasferiti ai consumatori attraverso commissioni più elevate o premi assicurativi maggiorati. La disparità di accesso alle tecnologie di protezione sta anche creando una nuova forma di divario digitale, dove solo coloro che possono permettersi soluzioni di sicurezza avanzate sono adeguatamente protetti, lasciando le popolazioni più vulnerabili, come gli anziani o le persone con limitate competenze digitali, particolarmente esposte a questi attacchi sofisticati. Un altro aspetto preoccupante è l’impatto sulle piccole imprese, che spesso non dispongono delle risorse per implementare contromisure adeguate contro attacchi basati sull’IA. Questo può portare a un consolidamento del mercato, con le grandi aziende che acquisiscono un vantaggio competitivo grazie alla loro capacità di investire in sicurezza avanzata, riducendo ulteriormente la diversità economica.

Le truffe via email potenziate dall’intelligenza artificiale hanno subito un’evoluzione drammatica, andando ben oltre i tradizionali tentativi di phishing. L’IA generativa ha permesso ai criminali informatici di abbandonare l’approccio “spray and pray” in favore di campagne altamente mirate e contestualizzate. I moderni attacchi via email basati sull’IA sono caratterizzati da una personalizzazione estrema: i sistemi analizzano dati provenienti da molteplici fonti – social media, data breach, comunicazioni aziendali pubbliche – per creare messaggi che fanno riferimento a dettagli specifici della vita o del lavoro della vittima. Molto efficaci sono le truffe che sfruttano eventi temporali o stagionali: l’IA può generare rapidamente email fraudolente relative a scadenze fiscali, emergenze sanitarie o persino riferimenti a eventi locali, conferendo urgenza e rilevanza contestuale che aumenta significativamente i tassi di successo. L’intelligenza artificiale viene anche utilizzata per infiltrarsi in conversazioni email esistenti, un attacco noto come “conversation hijacking”. I criminali accedono a una catena di email legittima, analizzano il linguaggio, il tono e il contesto della conversazione, e poi inseriscono messaggi fraudolenti che appaiono come risposte naturali alla discussione in corso. Questo tipo di attacco è davvero efficace perché sfrutta la fiducia già stabilita tra i partecipanti alla conversazione. Una tendenza emergente è l’uso dell’IA per creare email che imitano perfettamente lo stile di scrittura di persone conosciute dalla vittima. Analizzando campioni di comunicazioni precedenti, l’IA può replicare peculiarità linguistiche, espressioni preferite, abitudini di punteggiatura e persino errori tipici di una specifica persona, rendendo la falsificazione praticamente indistinguibile dall’originale. I truffatori stanno anche utilizzando l’intelligenza artificiale per ottimizzare i loro attacchi, testando automaticamente diverse varianti di email fraudolente su piccoli gruppi di destinatari e analizzando quali elementi – oggetti, approcci emotivi, richieste specifiche – generano i tassi di risposta più elevati. Questo processo di ottimizzazione continua rende le campagne di phishing sempre più efficaci nel tempo.

Il furto di identità potenziato dall’intelligenza artificiale ha raggiunto un livello di sofisticazione che rende queste frodi notevolmente più difficili da rilevare e contrastare rispetto ai metodi tradizionali. I criminali informatici stanno ora utilizzando l’IA per creare identità sintetiche complete, che combinano elementi di persone reali con dati generati artificialmente, creando persone “fantasma” che possono passare i controlli di verifica standard. Queste identità ibride sono insidiose perché possono includere elementi verificabili (come numeri di previdenza sociale di persone reali) mescolati con dettagli fittizi, rendendo estremamente difficile per i sistemi di sicurezza identificarle come fraudolente. L’IA generativa ha anche rivoluzionato la creazione di credenziali false, producendo documenti d’identità che includono caratteristiche di sicurezza avanzate come ologrammi, microincisioni e filigrane che possono ingannare anche gli operatori addestrati. Quando queste immagini di documenti vengono combinate con deepfake durante le verifiche di identità video, il rischio di frode aumenta esponenzialmente. Un aspetto preoccupante del furto di identità basato sull’IA è la capacità di questi sistemi di mantenere la coerenza tra molteplici punti di contatto. I criminali possono creare un’intera presenza online per un’identità rubata o sintetica, includendo profili social media realistici, storia creditizia, referenze professionali e persino recensioni o testimonianze su varie piattaforme. Questa coerenza multi-canale rende queste identità falsificate estremamente convincenti, poiché sembrano avere una storia digitale autentica verificabile attraverso diverse fonti. I sistemi di IA vengono utilizzati anche per monitorare e replicare i modelli comportamentali delle vittime reali. Analizzando le abitudini di spesa, gli schemi di utilizzo dei dispositivi e i modelli di comunicazione, i truffatori possono imitare il comportamento della vittima quando utilizzano l’identità rubata, riducendo la probabilità che attività insolite inneschino avvisi di frode. Le conseguenze del furto di identità potenziato dall’IA si estendono ben oltre le immediate perdite finanziarie, poiché queste identità sintetiche o rubate possono essere mantenute attive per anni, causando danni a lungo termine alla reputazione finanziaria e digitale delle vittime.

Le truffe basate sul riscatto e sull’estorsione hanno trovato nell’intelligenza artificiale generativa un potente alleato che ha notevolmente ampliato la portata e l’efficacia di questi attacchi. Il “sextortion” potenziato dall’IA rappresenta una delle varianti più dannose: i criminali utilizzano deepfake per inserire volti di vittime innocenti in contenuti pornografici, minacciando poi di distribuire questi falsi video o immagini se non viene pagato un riscatto. A differenza delle truffe di sextortion tradizionali, che spesso bluffavano sull’esistenza di tali contenuti, le versioni basate sull’IA possono effettivamente produrre materiale realistico per dimostrare la credibilità della minaccia, aumentando significativamente l’impatto psicologico e la probabilità di pagamento. Un’evoluzione particolarmente inquietante è l’uso dell’IA per creare minacce personalizzate basate su informazioni raccolte dalle vittime. I sistemi di intelligenza artificiale analizzano la presenza online delle potenziali vittime, identificando vulnerabilità specifiche, preoccupazioni personali o professionali, o dettagli che potrebbero causare particolare imbarazzo se rivelati. Queste informazioni vengono poi utilizzate per creare messaggi di estorsione altamente personalizzati che fanno leva sulle paure individuali della vittima. L’IA viene anche impiegata per automatizzare e scalare gli attacchi di “ransomware reputazionale”, dove i criminali minacciano di pubblicare informazioni dannose – reali o fabbricate – sulla vittima o sulla sua azienda. I sistemi di intelligenza artificiale possono generare comunicati stampa falsi, post sui social media o addirittura articoli di notizie che sembrano legittimi, dimostrando come il danno reputazionale potrebbe manifestarsi se il riscatto non viene pagato. Particolarmente preoccupante è l’emergere di campagne di estorsione basate su deepfake audio, dove i criminali creano registrazioni vocali falsificate della vittima che fa dichiarazioni compromettenti, esprime opinioni controverse o persino sembra pianificare attività illegali. Queste registrazioni vengono utilizzate come prova della necessità di pagare per evitare conseguenze personali o professionali. La natura automatizzata di questi attacchi consente ai criminali di condurre campagne di estorsione su larga scala, personalizzando le minacce per migliaia di potenziali vittime simultaneamente e concentrando poi gli sforzi su coloro che mostrano segni di vulnerabilità o propensione al pagamento.

Le frodi assicurative potenziate dall’IA rappresentano una frontiera emergente che sta causando preoccupazioni significative nel settore. I truffatori stanno utilizzando l’intelligenza artificiale generativa per creare prove false estremamente convincenti a supporto di richieste di risarcimento fraudolente. Ad esempio, i modelli di diffusione e le GAN possono generare immagini fotorealistiche di danni a veicoli, proprietà o beni personali che non si sono mai verificati realmente. Queste immagini sono abbastanza sofisticate da includere dettagli ambientali coerenti, condizioni di illuminazione appropriate e persino metadati che sembrano autentici. Nel contesto delle assicurazioni sanitarie, l’IA viene utilizzata per falsificare documenti medici, inclusi rapporti diagnostici, ricette, fatture ospedaliere e persino immagini radiografiche o ecografiche modificate. Questi documenti possono essere personalizzati con intestazioni di ospedali reali, firme di medici effettivamente esistenti e terminologia medica accurata, rendendo estremamente difficile per gli assicuratori identificarli come falsi senza indagini approfondite. Particolarmente sofisticato è l’uso dell’IA per creare testimonianze false correlate agli incidenti. I truffatori utilizzano modelli linguistici avanzati per generare dichiarazioni dettagliate di testimoni inesistenti, complete di elementi narrativi coerenti, dettagli specifici dell’incidente e persino incongruenze minori che paradossalmente aumentano la percezione di autenticità, poiché le testimonianze umane genuine raramente sono perfettamente lineari. I sistemi di IA vengono anche impiegati per identificare e sfruttare le vulnerabilità nelle procedure di elaborazione automatizzata delle richieste di risarcimento. Analizzando i modelli di approvazione e rifiuto, questi sistemi possono determinare quali tipi di richieste hanno maggiori probabilità di essere elaborate senza un esame manuale approfondito, permettendo ai truffatori di ottimizzare le loro frodi per evitare di attivare sistemi di rilevamento. Per contrastare queste minacce, le compagnie assicurative stanno a loro volta implementando soluzioni basate sull’IA per rilevare immagini generate artificialmente, inconsistenze nei documenti e altri segnali di frode, dando vita a una sorta di corsa agli armamenti tecnologici tra truffatori e assicuratori.

Il fenomeno delle truffe relative all’AI washing rappresenta un’evoluzione meta-fraudolenta nel panorama della sicurezza informatica. Con questo termine si indica la pratica di promuovere prodotti, servizi o investimenti falsamente presentati come basati sull’intelligenza artificiale avanzata per sfruttare l’entusiasmo e gli elevati valori di mercato associati a questa tecnologia. I truffatori creano elaborati siti web, white paper e presentazioni che descrivono soluzioni apparentemente rivoluzionarie basate sull’IA, utilizzando terminologia tecnica complessa e diagrammi impressionanti che in realtà nascondono l’assenza di qualsiasi tecnologia reale. Ironicamente, questi truffatori spesso utilizzano effettivamente l’IA generativa per creare questa documentazione falsa, con modelli linguistici avanzati che producono descrizioni tecniche convincenti di algoritmi e sistemi inesistenti. Un approccio particolarmente insidioso consiste nel presentare prodotti che sembrano utilizzare l’IA ma in realtà si basano su semplici automazioni o addirittura sul lavoro manuale umano nascosto. Ad esempio, servizi che promettono analisi dei dati basate sull’IA possono semplicemente impiegare lavoratori a basso costo per eseguire le analisi manualmente, mentre app che affermano di utilizzare algoritmi di machine learning per personalizzare contenuti potrebbero implementare semplici regole programmate senza alcuna reale capacità di apprendimento. Nel campo degli investimenti, l’AI washing ha dato origine a numerose criptovalute e token fraudolenti che affermano di utilizzare “algoritmi IA proprietari” per generare rendimenti straordinari. Questi progetti spesso presentano dashboard tecniche impressionanti con visualizzazioni di dati in tempo reale che sembrano mostrare l’IA al lavoro, ma sono in realtà simulazioni preprogrammate senza alcuna intelligenza sottostante. Le startup che praticano AI washing possono anche creare falsi video dimostrativi dove i risultati sono pre-registrati o manipolati, deepfake di “clienti soddisfatti” e persino false pubblicazioni accademiche che sembrano validare la loro tecnologia. La natura altamente tecnica e il rapido sviluppo del campo dell’IA rendono particolarmente difficile per i non esperti valutare la legittimità di queste affermazioni, creando un terreno fertile per questo tipo di frodi.

La difesa contro le truffe basate sull’intelligenza artificiale generativa richiede un approccio multilivello che combini consapevolezza, tecnologia e procedure di verifica rigorose. A livello individuale, è fondamentale sviluppare un sano scetticismo digitale, trattando con cautela tutte le comunicazioni non sollecitate, specialmente quelle che creano un senso di urgenza o che fanno appello a emozioni forti. È essenziale implementare l’autenticazione a più fattori su tutti gli account sensibili, utilizzando preferibilmente metodi basati su hardware come chiavi di sicurezza fisiche che sono immuni agli attacchi di phishing. Anche l’adozione di password manager e l’uso di password uniche per ogni servizio rappresentano misure difensive fondamentali. Per quanto riguarda l’identificazione di contenuti generati dall’IA, è importante prestare attenzione ai piccoli dettagli che spesso tradiscono la natura artificiale del materiale: incoerenze nelle immagini (come mani con dita extra o gioielli che cambiano tra fotogrammi nei video), firme illeggibili nei documenti, o imprecisioni logiche nelle narrazioni. Nel contesto delle transazioni finanziarie, è cruciale stabilire canali di verifica secondari indipendenti. Per esempio, se si riceve una richiesta di pagamento via email, è sempre consigliabile verificare attraverso una telefonata a un numero ufficiale noto (non quello fornito nell’email) o un’altra piattaforma di comunicazione. Per le aziende, investire in soluzioni di sicurezza basate sull’IA rappresenta un’importante contromisura, sfruttando le stesse tecnologie utilizzate dai truffatori per rilevare tentativi di frode. Questi sistemi possono identificare modelli linguistici anomali, riconoscere immagini generate artificialmente e rilevare comportamenti insoliti che potrebbero indicare un attacco in corso. Inoltre, è essenziale implementare politiche di autorizzazione multi-livello per transazioni significative, garantendo che nessuna azione importante possa essere intrapresa sulla base di una singola comunicazione o richiesta. La formazione continua del personale sui nuovi vettori di attacco è fondamentale, così come la creazione di una cultura organizzativa che incoraggi il reporting di attività sospette senza stigmatizzare chi potrebbe aver inizialmente interagito con una potenziale truffa.

In risposta alla crescente minaccia delle truffe basate sull’intelligenza artificiale generativa, sta emergendo un ecosistema di soluzioni tecnologiche progettate specificamente per rilevare e contrastare questi attacchi sofisticati. Le piattaforme di verifica dell’identità stanno evolvendo per includere controlli “liveness” avanzati che possono distinguere tra un volto reale e un deepfake, richiedendo azioni casuali come movimenti specifici della testa o espressioni facciali che sono difficili da replicare per i sistemi di IA in tempo reale. Parallelamente, stanno guadagnando terreno tecnologie di filigrana digitale che incorporano firme invisibili nei contenuti legittimi, permettendo di verificare l’origine e l’autenticità di immagini, video o documenti. Le soluzioni basate su blockchain offrono un approccio complementare, creando registri immutabili che possono essere utilizzati per verificare l’autenticità e la provenienza di contenuti digitali, stabilendo una “proof of origin” verificabile. Nel campo dell’analisi dei contenuti, stanno emergendo strumenti sempre più sofisticati per il rilevamento di testi generati dall’IA, capaci di identificare i pattern linguistici caratteristici dei modelli di linguaggio avanzati. Questi sistemi analizzano fattori come la diversità del vocabolario, la struttura delle frasi e le associazioni semantiche per distinguere tra testo scritto da umani e quello prodotto algoritmicamente. Per quanto riguarda le comunicazioni vocali, le tecnologie di autenticazione vocale stanno diventando più robuste, implementando analisi multidimensionali che esaminano non solo il timbro e l’intonazione della voce, ma anche micromodelli acustici che sono difficili da replicare per i sistemi di clonazione vocale. Le banche e le istituzioni finanziarie stanno integrando sistemi di monitoraggio comportamentale che tracciano i modelli di interazione degli utenti con i loro servizi, identificando anomalie che potrebbero indicare un account compromesso o un tentativo di frode. A livello di rete, tecnologie avanzate di rilevamento delle minacce utilizzano l’apprendimento automatico per identificare modelli di traffico sospetti o tentativi di impersonificazione, bloccando proattivamente le comunicazioni potenzialmente fraudolente prima che raggiungano gli utenti finali.

Il futuro delle truffe basate sull’intelligenza artificiale generativa e delle contromisure correlate presenta uno scenario in continua evoluzione, dove l’innovazione tecnologica gioca un ruolo fondamentale sia per gli attaccanti che per i difensori. Con l’avanzamento dei modelli di linguaggio e delle tecnologie generative, possiamo anticipare l’emergere di truffe ancora più sofisticate che combineranno diverse modalità – testo, voce, video, interazione in tempo reale – in esperienze fraudolente sempre più immersive e convincenti. Un’altra truffa pericolosa è la prospettiva di deepfake interattivi in tempo reale, dove un truffatore potrebbe impersonare una persona conosciuta dalla vittima in una videochiamata, rispondendo naturalmente alle domande e adattandosi dinamicamente alla conversazione, rendendo virtualmente impossibile rilevare l’inganno senza metodi di verifica esterni. Allo stesso tempo, possiamo prevedere l’emergere di un panorama normativo più robusto, con legislazioni specifiche che richiedono l’etichettatura o la filigrana digitale dei contenuti generati dall’IA, stabilendo responsabilità legali per l’uso fraudolento di queste tecnologie. La risposta tecnologica includerà probabilmente lo sviluppo di standard di autenticazione avanzati, come i protocolli “dati verificabili” che consentono di dimostrare crittograficamente l’origine e l’integrità dei contenuti digitali. Nel medio termine, potremmo assistere a una sorta di “corsa agli armamenti” dell’IA, dove sistemi di rilevamento sempre più sofisticati competono con tecniche di evasione in continua evoluzione. Questo potrebbe portare a un equilibrio instabile, con finestre di vulnerabilità che si aprono temporaneamente quando emergono nuove tecniche di inganno, prima che vengano sviluppate contromisure efficaci. A lungo termine, la soluzione più sostenibile potrebbe risiedere in un approccio di “sicurezza by design” per i sistemi di intelligenza artificiale generativa, con principi etici e meccanismi di sicurezza integrati a livello fondamentale nelle architetture dell’IA, piuttosto che aggiunti come strati di protezione successivi. Parallelamente, l’educazione digitale e l’alfabetizzazione all’IA diventeranno competenze fondamentali, consentendo agli individui di navigare in un panorama informativo sempre più complesso con maggiore consapevolezza e resilienza.

In conclusione, le truffe basate sull’intelligenza artificiale generativa rappresentano una sfida senza precedenti per la sicurezza digitale, combinando sofisticazione tecnologica con manipolazione psicologica in modi che erano inimmaginabili solo pochi anni fa. La rapidità con cui queste tecnologie si stanno evolvendo e la loro crescente accessibilità stanno creando un ambiente in cui anche gli utenti più cauti possono trovarsi vulnerabili a inganni elaborati e convincenti. Dall’impersonificazione vocale ai deepfake, dai documenti falsificati ai chatbot fraudolenti, l’IA generativa ha ampliato drasticamente il repertorio dei cybercriminali, rendendo le truffe più scalabili, personalizzate ed efficaci. Questa evoluzione richiede un ripensamento fondamentale del nostro approccio alla sicurezza digitale, passando da un modello basato principalmente sulla vigilanza individuale a un ecosistema di protezione integrato che combina tecnologia avanzata, quadri normativi appropriati e alfabetizzazione digitale diffusa. Le tecnologie di rilevamento basate sull’IA, l’autenticazione multifattoriale robusta e i sistemi di verifica dell’identità avanzati rappresentano importanti linee di difesa, ma devono essere accompagnati da una maggiore consapevolezza collettiva dei rischi e delle tecniche di manipolazione. In ultima analisi, la risposta più efficace a questa nuova era di truffe digitali risiede in un approccio collaborativo che coinvolge sviluppatori di tecnologia, istituzioni, educatori e utenti finali, lavorando insieme per creare un ambiente digitale in cui l’innovazione tecnologica possa prosperare senza compromettere la sicurezza e la fiducia. La sfida è considerevole, ma con le giuste strategie, tecnologie e consapevolezza, è possibile costruire una resilienza collettiva contro anche le forme più sofisticate di inganno digitale. In questo contesto in continua evoluzione, rimanere informati, adattabili e critici rappresenta la nostra migliore difesa contro le minacce emergenti, permettendoci di navigare con maggiore sicurezza attraverso il complesso paesaggio digitale contemporaneo.

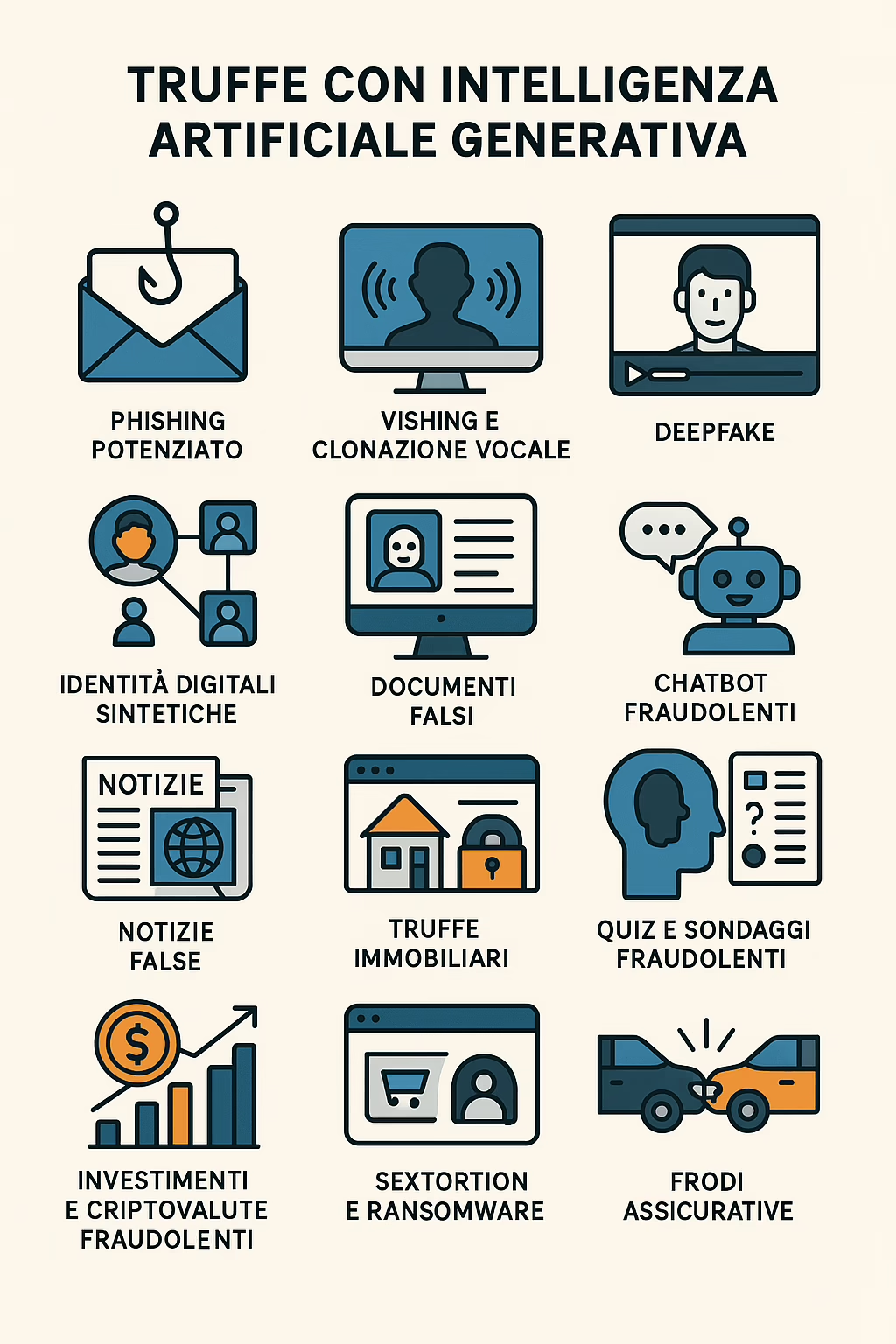

RICAPITOLANDO:

I principali tipi di truffe descritti sono:

- Phishing potenziato: Email professionali e personalizzate, che imitano perfettamente lo stile aziendale, rendendo gli attacchi quasi indistinguibili da comunicazioni reali.

- Vishing e clonazione vocale: L’IA viene usata per imitare le voci di dirigenti o familiari, ingannando le vittime a compiere azioni finanziarie o divulgare informazioni sensibili.

- Deepfake: Video e immagini manipolati per ingannare, come falsi video di CEO o di celebrità, usati per frodi o ricatti.

- Identità digitali sintetiche: L’IA crea profili falsi sui social network che sembrano estremamente realistici, utilizzati per truffe romantiche, professionali o di phishing.

- Documenti falsi: L’IA è capace di generare documenti contraffatti di alta qualità, che ingannano persino i sistemi di verifica automatizzati.

- Chatbot fraudolenti: Chatbot IA che simulano supporto tecnico o rappresentanti finanziari per rubare informazioni sensibili.

- Manipolazione delle recensioni online: L’IA genera recensioni false per gonfiare la reputazione di prodotti fraudolenti.

- Notizie false: Siti clonati e articoli ingannevoli creati con l’IA per manipolare l’opinione pubblica o il mercato finanziario.

- Truffe immobiliari: Annunci di vendita o affitto di proprietà inesistenti, con immagini fotorealistiche generate dall’IA.

- Sistemi di pagamento: Interfacce di pagamento false, indistinguibili da quelle reali.

- Quiz e sondaggi: Domande apparentemente innocue che raccolgono dati sensibili, utilizzati poi per furti di identità o phishing.

- Investimenti e criptovalute fraudolenti: Ecosistemi fittizi di investimento creati per attrarre investitori con false promesse di rendimenti.

- Sextortion e ransomware: Minacce di pubblicare foto o video falsi generati dall’IA per estorcere denaro.

- Frodi assicurative: Generazione di prove fittizie (come immagini di incidenti) per ottenere risarcimenti illeciti.

Mi raccomando, come sempre state attentionline.it